Analityka internetowa. Jakie zmiany nas czekają i jak się do nich przygotować?

Teraz możesz się skupić, bo analityka internetowa to nie są takie małe miki. To poważna sprawa. A jak to bywa z takimi sprawami – nie jest łatwo. Czy kiedyś było jakoś łatwiej? Oczywiście, że tak. Tylko pomyśl – Universal Analytics, niczym niezakłócone śledzenie całego ruchu na stronie WWW, brak konieczności zbierania zgód – tylko użytkownicy cieszący się życiem. Kiedyś to były czasy, teraz nie ma czasów. No, a jako, że kiedyś było nas jedenaścioro i mieszkaliśmy w jeziorze, to wiemy, co mówimy.

Ale z analityką internetową, jak z życiem – były łatwiejsze czasy, teraz są trudniejsze, ale radzić sobie trzeba. Kto kombinuje, ten żyje. I – uwaga – też sobie poradzisz. Tylko trzeba podejść do tego ze spokojem i wiedzą, którą pomożemy Ci usystematyzować w naszym artykule.

Traktujesz Google Analytics jak wyrocznię? Przestań!

Google Analytics w poprzedniej odsłonie rozleniwił wszystkich:

- Marketerów w agencjach – bo łatwo można było znaleźć jakąkolwiek inną, sensowną odpowiedź dla klienta, który wymaga czegoś więcej niż “to zależy”.

- Właścicieli biznesów/dyrektorów marketingu – bo liczby i wartości konwersji w Universal Analytics bywały bardzo zbliżone do realnych, więc łatwo można było podejmować taktyczne decyzje dotyczące tego w jaki kanał marketingowy warto zainwestować, a jaki odpuścić.

- Freelancerów – bo implementacja Google Analytics wyglądała z boku jak organizacja lotu w kosmos, a w istocie była stosunkowo prosta i satysfakcjonująca. Prawie tak jak umycie przedniej szyby po podróży autostradą.

Google Analytics 4 jest z nami już od 4 lat (ależ ten czas zasuwa..), a od niemal roku jest główną usługą analityczną w działaniach digital marketingowych. Jego wdrożenie w wielu firmach rodziło się w bólach, trwało tygodniami, a efekty często okazywały się być rozczarowujące. Dlaczego? Spadki w większości KPI, niekiedy kiepskie pokrycie danych o konwersji z rzeczywistością (zwłaszcza jeśli GA4 został wdrożony wraz z Consent Mode), mało intuicyjny interfejs itp. itd. Czyli, jakby to pewnie określił Bartosz Walaszek – może i jest drożej, ale za to średnio.

Dane danym nierówne

Czy to wszystko wina Google Analytics i wystarczy zmienić narzędzie, by wrócić do tego co było? Nie, po prostu zmieniły się realia i trzeba zacząć podchodzić do tematu analizowania danych inaczej niż w minionych latach. Jak? Jak profesjonalista – wiadomo, zbuduj hierarchię swoich danych według ich jakości

- Dane kanoniczne – z Twojego CRM-a lub systemu sklepowego – dane w oparciu, o które rozliczasz się z efektów biznesowych. Z definicji powinny być najbardziej spójne z rzeczywistością i do nich powinn_ś mieć największe zaufanie. Uzupełnieniem danych kanonicznych powinny być wszelkiego rodzaju dane makroekonomiczne, branżowe raporty czy informacje z rynku.

- Dane analityczne – wszystkie informacje, których pozyskanie umożliwia analityka internetowa na Twojej stronie WWW i aplikacji. Nie tylko z GA4 ale też np. z PIWIK Pro albo Matomo. Pomogą Ci w analizowaniu trendów dotyczących źródeł ruchu oraz zachowań Twoich użytkowników.

- Dane optymalizacyjne – z systemów reklamowych – czyli informacje, na których bazują Twoje kampanie reklamowe

Czy te trzy źródła danych pokażą 3 różne liczby konwersji? Jest to możliwe – dlatego istotne jest zbudowanie hierarchii ważności oraz pewnego rodzaju SSoT – Single Source of Truth. Miejsca w którym dane zostają ze sobą zestawione oraz prezentują Tobie źródło wiedzy, na bazie której podejmiesz odpowiednie decyzje biznesowe.

Jak to jest w tej analityce, dobrze?

To nie jest tak, że jest dobrze, albo niedobrze. Jednak jest kilka spraw, które trzeba mieć na uwadze, żeby było dobrze.

| ŹLE | DOBRZE |

| Brak wdrożonego Consent Mode 2.0 | Wdrożenie Consent Mode 2.0 |

| Implementacja tagów śledzących bezpośrednio w kodzie strony | Implementacja za pośrednictwem Google Tag Managera |

| Pozostawienie kodów śledzących Universal Analytics na swojej stronie | Jedynie kod Google Analytics 4 (lub inne narzędzia analityczne) na Twojej stronie |

| Błędy w konfiguracji konwersji | Konwersje skonfigurowane poprawnie z odpowiednimi parametrami |

| Postawienie tylko na analitykę ilościową | Analityka ilościowa wsparta analizą jakościową |

No to o co tu właściwie chodzi?

Consent Mode v2

Znany nam od 2015 roku temat trybu zgody powraca z datą ostatecznego terminu wdrożenia. Od 6 marca 2024 nowa wersja jest obowiązkowa. Niedostosowanie metod zbierania danych bez jej uwzględnienia niesie za sobą przykre konsekwencje.

Związany ściśle z ochroną prywatności w sieci Akt o rynkach cyfrowych ma na celu wyrównanie poziomu konkurencji na rynkach Europejskiego Obszaru Gospodarczego. Obowiązek dostosowania się obowiązuje na terenie strefy, a rozporządzenie wyznacza tzw. gatekeeperów – strażników dostępu. Są to firmy, na które w przypadku niedotrzymania postanowień mogą zostać nałożone kary w wysokości nawet do 20% globalnego dochodu w przypadku systematycznych naruszeń postanowień aktu. Do słynnych strażników należą same znajome korporacje: Google, Microsoft, Apple, Meta, Amazon, TikTok.

To jaki to ma związek z nami, grzecznymi marketerami? Wymusza to na nas wprowadzenie dodatkowych parametrów, które umożliwią użytkownikowi naszej strony wyrażenie zgody na zapisywanie i przetwarzanie danych z wizyt. Te parametry to ad_personalization i ad_user_data. Dzięki nim możemy śledzić konwersje, tworzyć listy remarketingowe i używać ich, by kierować do użytkowników personalizowane reklamy.

Czyli:

✔️ trafimy do odpowiedniego grona osób,

✔️ nie przepalimy budżetu,

✔️ nie narazimy się na konsekwencje prawne.

Trzeba? Trzeba!

Retencja danych w GA4

Jak w 2023 roku dowiedzieliśmy się o zbliżającym się unicestwieniu Universal Analytics, to wiedzieliśmy, że trzeba działać szybko. Proponowanym rozwiązaniem było jak najrychlejsze uruchomienie Google Analytics 4. Wszyscy, którzy wtedy wdrożyli to rozwiązanie niedługo staną przed trudną decyzją.

Okno retencji danych w GA4 to 14 miesięcy. Szybka matma: jeśli zaimplemetowaliśmy nowe rozwiązanie tak, jak głosiła rekomendacja (czyli w lipcu 2023), dane zbierać będą się do września 2024. Gotowi pożegnać się z tym, co uskładaliśmy na swoją bezpieczną kupkę?

No my niekoniecznie. Zbierać dane po to, by rok później je stracić to cios, przed którym chcemy, niczym Rocky, zrobić skuteczny unik. Ten ruch ma swoją nazwę: BigQuery.

Do tych przenosin potrzebujemy tylko jednej firmy przeprowadzkowej – Google Cloud Platform. Tam skonfigurujemy usługę BigQuery dla danych z GA4 i zbierzemy dane także z Google Ads, Meta Ads, Google Merchant Centre, Amazona, a nawet Salesforce. Zwizualizować dane możemy później w Looker Studio, który umożliwia stworzenie praktycznych i wysoce dostosowywalnych raportów to w końcu jego domena.

Z artykułu Kuby dowiesz się więcej, chociażby o kosztach.

Privacy sandbox – czy ciasteczkom powiemy “papa”?

Privacy sandbox – idea będąca próbą dość karkołomnego kompromisu pomiędzy prywatnością użytkowników a potrzebami reklamodawców i wydawców. Samą ideę można określić jako próbę stworzenia zupełnie nowych zasad gry w świecie internetu – zapewniającego większą prywatność.

Na czym będzie polegać?

- Śledzenie użytkowników między stronami (cross-site tracking) zostanie zastąpione nowymi mechanizmami, które nie będą wymagały używania ciasteczek (cookies) zewnętrznych firm. Zamiast tego dane o zainteresowaniach użytkowników będą przechowywane lokalnie w przeglądarce użytkownika.

- Wycofanie obsługi ciasteczek zewnętrznych firm (third-party cookies) w przeglądarce Chrome – obecnie to główne narzędzie do śledzenia użytkowników w celach reklamowych.

- Ograniczenie możliwości tworzenia cyfrowych odcisków palców (fingerprinting), które umożliwiają identyfikację użytkowników bez użycia ciasteczek

Trafne reklamy mają być dostarczane do właściwych użytkowników dzięki zastosowaniu API Topics, które pozwoli określać zainteresowania użytkowników na podstawie ich historii przeglądania, a dane te będą przechowywane tylko lokalnie w przeglądarce. Wiele mówi się o tym, że taka zmiana może nastąpić jeszcze w 2024 roku. Choć termin ten już kilkukrotnie ulegał zmianie, więc jest możliwe, że i ten deadline będzie przesuwany.

Analityka internetowa spotyka AI

Nie tylko do generowania obrazów, pisania prac, wymyślania życzeń urodzinowych. Sztuczna Inteligencja to także pomoc przy opracowywaniu raportów, wyciąganiu wniosków z dużych wolumenów danych, a także sporządzaniu wizualizacji trendów. Nawet dzięki zastosowaniu właśnie BigQuery możliwe staje się stworzenie modelu predykcyjnego, który zasugeruje Ci co może dziać się z Twoim biznesem w najbliższym czasie.

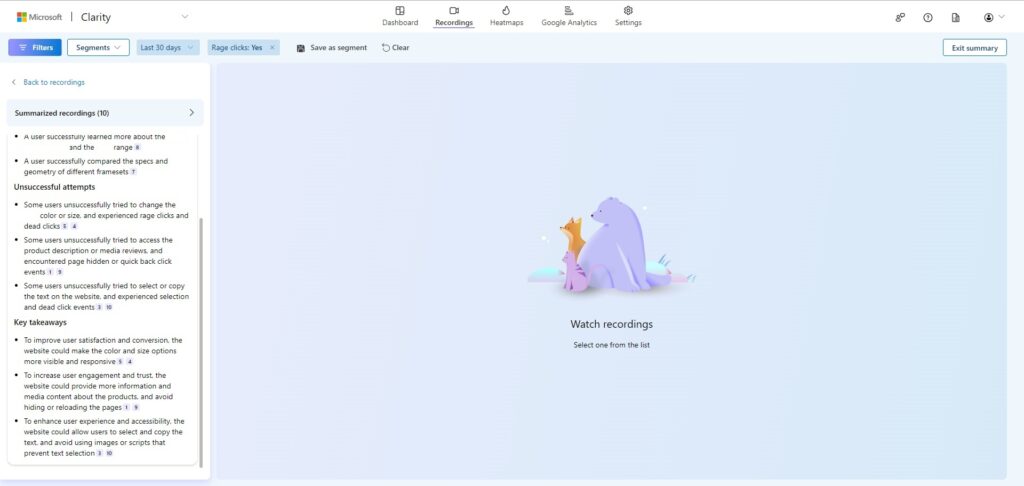

Dostępne są także rozwiązania AI wbudowane w narzędzia takie jak np. Microsoft Clarity. Dzięki niemu możemy (oczywiście, po uzyskaniu na to zgody użytkownika 😉 obserwować jego zachowanie na stronie. “Ale zaraz, to nie jest nic nowego, przecież taki HotJar jest na rynku już od dawna” – powiesz. Clarity używa AI do podsumowywania i oferowania wniosków z nagrań. Możesz filtrować sesje, budować segmenty użytkowników, a potem kliknąć jeden guzik i otrzymać najważniejsze wnioski z grupy nagrań.

Dzięki temu dużo łatwiej wykryjesz błędy na stronie, możliwe źródło frustracji swoich potencjalnych klientów, a nawet powód porzucania przez nich koszyków. A Microsoft dostarcza nam takie możliwości za darmo. Bajka!

Single Source of Truth

Budowa jednego “hubu” informacyjnego dotyczącego skuteczności Twojego marketingu w dobie rozproszonych informacji, może okazać się najlepszym sposobem na opanowanie chaosu w Twojej organizacji.

Dlaczego jest to takie ważne? Przykładowo – Google Analytics pokazuje, że Twoja firma usługowa w ciągu ostatnich 30 dni zdobyła 40 nowych kontaktów do potencjalnych klientów, a wewnętrzny CRM raportuje 45 konwersji. Jeśli Twoje dane nie integrują się ze sobą w jednym miejscu i ciężko je ze sobą skonfrontować, całkiem możliwe, że bazując na GA4 spędzisz trochę czasu na poszukiwaniu “brakujących” 5 formularzy. A wystarczy tylko zerknąć do CRM-a, by wszystko było jasne. Podobne sytuacje można mnożyć, a im więcej danych analitycznych będzie “wycinanych”, tym rola danych kanonicznych będzie coraz większa.

Jak stworzyć Single Source of Truth (SSoT)?

Bazując na integracji źródeł danych w jednym miejscu oraz automatyzowaniu przepływów najbardziej istotnych informacji. Jednym z filarów SSoT są aktualne dane, które na bieżąco się aktualizują w zgodzie z ustaloną przez Ciebie hierarchią informacji. Drugim są wszelkiego rodzaju dokumentacje, wiedza zgromadzona przez Twoją organizację. Jej rozproszenie również niekorzystnie wpływa na czas poświęcany na poszukiwanie wiedzy, która już kiedyś została zebrana w Twojej organizacji. Dobrymi narzędziami do budowy SSoT będą takie aplikacje jak np.:

- Notion

- Clickup

- Airtable

- Asana

- Obsidian

Nie taka analityka internetowa straszna…

Czasy kiedy analityka internetowa była prosta dobiegły końca. Wymagane wdrożenie trybu zgody, dane rozsiane po ekosystemach, wycofanie ciasteczek. To niezbyt wesołe realia dzisiejszego digital marketingu. Oznacza to konieczność adaptacji do nowych rozwiązań, na które jesteśmy gotowi i wdrażamy na co dzień. Jeśli potrzebujesz wsparcia, bo analityka internetowa to dla Ciebie wciąż czarna magia – napisz do nas, razem pokonamy te przeszkody! 🙂